Google谷歌如何解讀robots.txt規范

日期:2025年1月15日Google 的自動抓取工具支持 REP(robots 協議)。這意味著,在抓取某一網站之前,Google 抓取工具會下載并解析該網站的 robots谷歌object detection

Google 的自動抓取工具支持 REP(robots 協議)。這意味著,在抓取某一網站之前,Google 抓取工具會下載并解析該網站的 robots谷歌object detection

向搜索引擎要流量要訂單!一個好網站不僅要滿足用戶需求還要符合SEO規則。

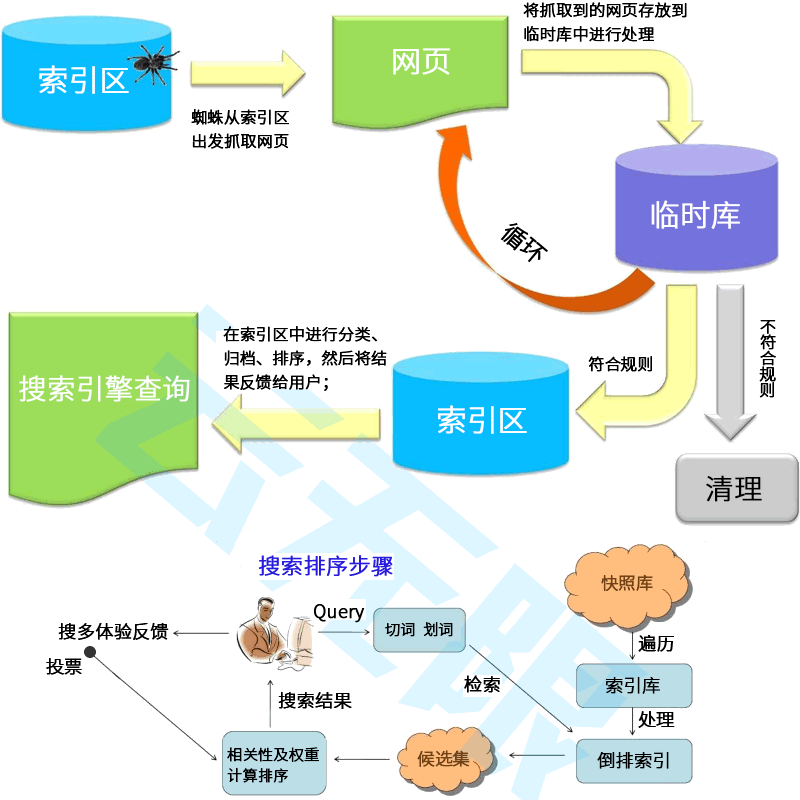

SEO的專業性遠超你的想象!我們要做的是協助搜索引擎而不是欺騙它!它涉及到的不止是網站結構、內容質量、用戶體驗、外部鏈接這幾個方面;還有算法的更替、蜘蛛的引導、快照的更新、參與排序的權重等。

一、讓用戶搜到你的網站是做SEO優化的目標,擁有精湛的SEO技術、豐富的經驗技巧以及對SEO規則的深刻把握才有機會獲得更多展現機會!

二、確保網站內容清晰、準確、易于理解,使用戶能夠輕松找到所需信息.使用簡潔明了的標題和描述,幫助用戶快速了解你的產品服務!

三、將企業的核心價值、差異化賣點、吸引眼球的宣傳語等品牌詞盡可能多的占位搜索前幾頁,增強用戶印象,優化用戶體驗讓訪客信任你!

四、優化落地頁引導用戶咨詢或預約留言,引用大型案例或權威報道彰顯品牌實力,關注用戶需求和反饋,不斷優化產品服務讓用戶選擇你!

讓用戶搜到你、信任你、選擇你!

Google 的自動抓取工具支持 REP(robots 協議)。這意味著,在抓取某一網站之前,Google 抓取工具會下載并解析該網站的 robots.txt 文件,以提取關于網站中哪些部分可以被抓取的信息。REP 不適用于由用戶控制的 Google 抓取工具(例如 Feed 訂閱),也不適用于用來提高用戶安全性的抓取工具(例如惡意軟件分析)。

本文介紹了 Google 對 REP 的解讀。有關原始草稿標準的信息,請查看 IETF Data Tracker。 如果您是首次接觸 robots.txt,請先閱讀我們的 robots.txt 簡介。您還可以找到關于創建 robots.txt 文件的提示,以及一個詳盡的常見問題解答列表。

如果您不希望抓取工具訪問您網站中的部分內容,可以創建包含相應規則的 robots.txt 文件。robots.txt 文件是一個簡單的文本文件,其中包含關于哪些抓取工具可以訪問網站的哪些部分的規則。例如,example.com 的 robots.txt 文件可能如下所示:

# This robots.txt file controls crawling of URLs under https://example.com.

# All crawlers are disallowed to crawl files in the "includes" directory, such

# as .css, .js, but Googlebot needs them for rendering, so Googlebot is allowed

# to crawl them.

User-agent: *

Disallow: /includes/

User-agent: Googlebot

Allow: /includes/

Sitemap: https://example.com/sitemap.xml

您必須將 robots.txt 文件放在網站的頂級目錄中,并為其使用支持的協議。就 Google 搜索而言,支持的協議包括 HTTP、HTTPS 和 FTP。使用 HTTP 和 HTTPS 協議時,抓取工具會使用 HTTP 無條件 GET 請求來提取 robots.txt 文件;使用 FTP 時,抓取工具會使用標準 RETR (RETRIEVE) 命令,并采用匿名登錄方式。

robots.txt 文件中列出的規則只適用于該文件所在的主機、協議和端口號。

和其他網址一樣,robots.txt 文件的網址也區分大小寫。

下表列出了 robots.txt 網址及其適用的網址路徑的示例。

robots.txt 網址示例 http://example.com/robots.txt 適用于:在請求 robots.txt 文件時,服務器響應的 HTTP 狀態代碼會影響 Google 抓取工具使用 robots.txt 文件的方式。下表總結了 Googlebot 針對各種 HTTP 狀態代碼處理 robots.txt 文件的方式。

錯誤處理和 HTTP 狀態代碼 2xx(成功) 表示成功的 HTTP 狀態代碼會提示 Google 抓取工具處理服務器提供的 robots.txt 文件。 3xx(重定向) Google 會按照 RFC 1945 的規定跟蹤至少五次重定向,然后便會停止,并將其作為 robots.txt 的 404 錯誤來處理。這也適用于重定向鏈中任何被禁止訪問的網址,因為抓取工具會由于重定向而無法提取規則。Google 通常會將 robots.txt 文件的內容最多緩存 24 小時,但在無法刷新緩存版本的情況下(例如出現超時或 5xx 錯誤時),緩存時間可能會延長。已緩存的響應可由各種不同的抓取工具共享。Google 會根據 max-age Cache-Control HTTP 標頭來延長或縮短緩存生命周期。

robots.txt 文件必須是采用 UTF-8 編碼的純文本文件,且各行代碼必須以 CR、CR/LF 或 LF 分隔。

Google 會忽略 robots.txt 文件中的無效行,包括 robots.txt 文件開頭處的 Unicode 字節順序標記 (BOM),并且只使用有效行。例如,如果下載的內容是 Html 格式而非 robots.txt 規則,Google 會嘗試解析內容并提取規則,而忽略其他所有內容。

同樣,如果 robots.txt 文件的字符編碼不是 UTF-8,Google 可能會忽略不屬于 UTF-8 范圍的字符,從而可能會導致 robots.txt 規則無效。

Google 目前強制執行的 robots.txt 文件大小限制是 500 KiB,并忽略超過該上限的內容。您可以通過整合會導致 robots.txt 文件過大的指令來減小 robots.txt 文件的大小。例如,將已排除的內容放在一個單獨的目錄中。

有效的 robots.txt 行由一個字段、一個冒號和一個值組成。可以選擇是否使用空格,但建議使用空格,有助于提高可讀性。系統會忽略行開頭和結尾的空格。若要添加注釋,請在注釋前面加上 # 字符。請注意,# 字符后面的所有內容都會被忽略。常見格式為 <field>:<value><#optional-comment>。

Google 支持以下字段:

user-agent:標識相應規則適用于哪些抓取工具。

allow:可抓取的網址路徑。

disallow:不可抓取的網址路徑。

sitemap:站點地圖的完整網址。

allow 和 disallow 字段也稱為指令。這些指令始終以 directive: [path] 的形式指定,其中 [path] 可以選擇性使用。默認情況下,指定的抓取工具沒有抓取限制。抓取工具會忽略不帶 [path] 的指令。

如果指定了 [path] 值,該路徑值就是 robots.txt 文件所在網站的根目錄的相對路徑(使用相同的協議、端口號、主機和域名)。路徑值必須以 / 開頭來表示根目錄,該值區分大小寫。詳細了解基于路徑值的網址匹配。

user-agent

user-agent 行用來標識相應規則適用于哪些抓取工具。請參閱 Google 抓取工具和用戶代理字符串,獲取可在 robots.txt 文件中使用的用戶代理字符串的完整列表。

user-agent 行的值不區分大小寫。

disallow

disallow 指令用來指定不能被 disallow 指令所屬的用戶代理行所標識的抓取工具訪問的路徑。抓取工具會忽略不含路徑的指令。

Google 無法將禁止抓取的網頁的內容編入索引,但可能仍會將其網址編入索引并將其顯示在搜索結果中,但不顯示摘要。了解如何阻止編入索引。

disallow 指令的值區分大小寫。

用法:

disallow: [path]

allow

allow 指令用來指定相應抓取工具可以訪問的路徑。如果未指定路徑,該指令將被忽略。

allow 指令的值區分大小寫。

用法:

allow: [path]

sitemap

根據 sitemaps.org 規定,Google、Bing 和其他主流搜索引擎支持 robots.txt 中的 sitemap 字段。

sitemap 字段的值區分大小寫。

用法:

sitemap: [absoluteURL]

[absoluteURL] 行指向站點地圖或站點地圖索引文件的位置。 此網址必須是完全限定網址,包含協議和主機,且無需進行網址編碼。此網址不需要與 robots.txt 文件位于同一主機上。您可以指定多個 sitemap 字段。sitemap 字段不依賴于任何特定的用戶代理,只要未被禁止抓取,所有抓取工具都可以追蹤它們。

例如:

user-agent: otherbot

disallow: /kale

sitemap: https://example.com/sitemap.xml

sitemap: https://CDN.example.org/other-sitemap.xml

sitemap: https://ja.example.org/テスト-サイトマップ.xml

通過對每個抓取工具重復 user-agent 行,可將適用于多個用戶代理的規則組合在一起。

例如:

user-agent: a

disallow: /c

user-agent: b

disallow: /d

user-agent: e

user-agent: f

disallow: /g

user-agent: h

此示例中有四個不同的規則組:

用戶代理"a"為一組

用戶代理"b"為一組

用戶代理"e"和"f"為一組

用戶代理"h"為一組

有關組的技術說明,請參閱 REP 的第 2.1 節。

對于某個抓取工具而言,只有一個組是有效的。Google 抓取工具會在 robots.txt 文件中查找包含與抓取工具的用戶代理相匹配的最具體用戶代理的組,從而確定正確的規則組。其他組會被忽略。所有非匹配文本都會被忽略(例如,googlebot/1.2 和 googlebot* 均等同于 googlebot)。這與 robots.txt 文件中的組順序無關。

如果為用戶代理聲明多個特定組,則這些組中適用于該特定用戶代理的所有規則會在內部合并成一個組。 特定于用戶代理的組和全局組 (*) 不會合并。

示例

user-agent 字段的匹配情況

user-agent: googlebot-news

(group 1)

user-agent: *

(group 2)

user-agent: googlebot

(group 3)

以下為抓取工具選擇相關組的方法:

每個抓取工具追蹤的組 Googlebot News googlebot-news 遵循組 1,因為組 1 是最具體的組。 Googlebot(網絡) googlebot 遵循組 3。 Googlebot Images googlebot-images 遵循組 2,因為沒有具體的 googlebot-images 組。 Googlebot News(抓取圖片時) 抓取圖片時,googlebot-news 遵循組 1。 googlebot-news 不會為 Google 圖片抓取圖片,因此它只遵循組 1。 Otherbot(網絡) 其他 Google 抓取工具遵循組 2。 Otherbot(新聞) 抓取新聞內容但未標識為 googlebot-news 的其他 Google 抓取工具遵循組 2。即使有相關抓取工具的對應條目,也只有在明確匹配時才會有效。規則分組

如果 robots.txt 文件中有多個組與特定用戶代理相關,則 Google 抓取工具會在內部合并這些組。例如:

user-agent: googlebot-news

disallow: /fish

user-agent: *

disallow: /carrots

user-agent: googlebot-news

disallow: /shrimp

抓取工具會根據用戶代理在內部對規則進行分組,例如:

user-agent: googlebot-news

disallow: /fish

disallow: /shrimp

user-agent: *

disallow: /carrots

allow、disallow 和 user-agent 以外的其他規則會被 robots.txt 解析器忽略。這意味著以下 robots.txt 代碼段被視為一個組,因此 user-agent a 和 b 均受 disallow: / 規則的影響:

user-agent: a

sitemap: https://example.com/sitemap.xml

user-agent: b

disallow: /

當抓取工具處理 robots.txt 規則時,會忽略 sitemap 行。 例如,下面說明了抓取工具如何理解之前的 robots.txt 代碼段:

user-agent: a

user-agent: b

disallow: /

Google 會以 allow 和 disallow 指令中的路徑值為基礎,確定某項規則是否適用于網站上的特定網址。為此,系統會將相應規則與抓取工具嘗試抓取的網址的路徑部分進行比較。 路徑中的非 7 位 ASCII 字符可以按照 RFC 3986 作為 UTF-8 字符或百分號轉義的 UTF-8 編碼字符納入。

對于路徑值,Google、Bing 和其他主流搜索引擎支持有限形式的通配符。這些通配符包括:

* 表示出現 0 次或多次的任何有效字符。

$ 表示網址結束。

路徑匹配示例 / 匹配根目錄以及任何下級網址。 /* 等同于 /。結尾的通配符會被忽略。 /$ 僅匹配根目錄。任何更低級別的網址均可抓取。 /fish 匹配以 /fish 開頭的任何路徑。匹配 robots.txt 規則與網址時,抓取工具會根據規則路徑的長度使用最具體的規則。如果規則(包括使用通配符的規則)存在沖突,Google 將使用限制性最弱的規則。

以下示例演示了 Google 抓取工具會對特定網址應用什么規則。

示例情況 http://example.com/page allow: /p

TAG:谷歌object detection

如果你的網站無法從搜索引擎獲取流量和訂單!說明你從一開始就沒有建立正確的SEO策略。

1、不限關鍵詞數量,不限關鍵詞指數,自由擴展.

2、更懂用戶搜索習慣、更懂SEO規則、更懂運營.

3、專業團隊實施,量化交付、效果持續有保障.

1、讓網站結構、內部標簽及HTML代碼等更符合SEO規則.

2、客戶指定關鍵詞,不限關鍵詞指數,不上首頁不收費.

3、提升搜索蜘蛛抓取效率、收錄效率、排名展現和有效訪問.

1、競爭對手分析,了解同行營銷策略以及行業趨勢.

2、關鍵詞保證到谷歌首頁帶來高價值流量及詢盤.

3、涵蓋Google、Bing、Yahoo等所有搜索引擎友好抓取.

世界上從不缺產品,缺的是把產品賣出去的方法!云優化是北京專業的SEO公司,專注百度、谷歌、搜狗、360等搜索引擎優化服務。我們更懂用戶搜索習慣、更懂SEO規則、更懂網站運營和SEO排名技術。

同等成本,讓您的關鍵詞排名更靠前;同樣市場,為您鎖定目標客戶快速吸引詢盤

用SEO技術讓客戶搜到你!讓你的品牌詞、核心詞和產品詞盡可能多的占位搜索首頁讓客戶信任你!改進用戶體驗直達落地頁,引導用戶咨詢或預約留言,突出產品差異化賣點,用案例和權威報道增強品牌公信力讓客戶選擇你!

SEO網站優化是一項持續且精細化的工作,而非一勞永逸。它要求優化師密切關注行業動態,深入分析數據,并根據這些洞察不斷調整和優化策略。云優化堅信,在SEO的旅程中,耐心和毅力是不可或缺的驅動力。只有持之以恒地投入努力,不斷優化網站,才能在激烈的網絡環境中脫穎而出,取得更為優異的搜索引擎排名。

搜索引擎優化聚焦于站內優化、站外SEO及搜索體驗。以客戶為中心,追求轉化價值最大化,遵循用戶需求和搜索規則,是成功的關鍵。文章作為優化的一環,不僅要滿足讀者,還需符合搜索引擎抓取規則。被收錄的文章才有機會參與排序。因此,明確主題、合理結構、段落清晰,并結合關鍵詞與主題的SEO規則創作,是文章發布的必備要素。

搜索引擎優化(SEO)與競價推廣共同構成了搜索引擎營銷(SEM),因其精準滿足客戶搜索需求,成為中小企業網站營銷的優選。SEM利用搜索引擎這一流量樞紐,精準捕獲目標客戶,助力品牌建設。無論在國內市場,借助百度、搜狗、360,還是國際市場,利用谷歌、必應、雅虎,SEM都能成為您營銷的強大助力。無論國內還是國際,SEM都是一項高效、精準的營銷策略。

許多優化師對SEO效果持疑,但云優化認為,這更多與網站SEO策略相關。關鍵詞排名雖受多因素影響,但正確思維和規范操作是關鍵。在網站上線前,深入分析并調整SEO,確保站內優化到位。平衡用戶需求和搜索引擎規則,可提升網站轉化率。因此,科學的SEO策略將助力網站取得更好效果。